NAMs出版プロジェクト: スピノザ、諸感情の定義:メモ

http://nam-students.blogspot.jp/2010/09/blog-post.html

NAMs出版プロジェクト: 諸感情の定義:再考

http://nam-students.blogspot.jp/2014/12/blog-post_6.html

NAMs出版プロジェクト: 感情の一覧 - Wikipedia

http://nam-students.blogspot.jp/2016/02/wikipedia.html

http://nam-students.blogspot.jp/2016/02/wikipedia.html

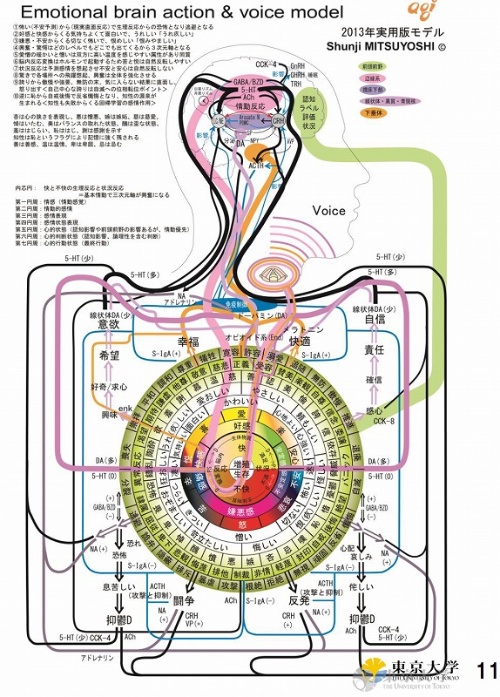

Emotional brain action & voice model

http://nam-students.blogspot.jp/2016/05/emotional-brain-action-voice-model.html(本頁)

[PDF]音声脳神経分析技術の応用 - AGI

Ph D. Shunji Mitsuyoshi, 光吉俊二

http://www.agi-web.co.jp/docs/Univ-Tokyo.pdf

NHKスペシャル「天使か悪魔か 羽生善治 人工知能を探る」[字][再] 5/18 (水) 0:10 ~ 1:00 (50分) NHK総合・東京(Ch.1)

ソフトバンクロボティクスが開発するロボット「Pepper(ペッパー)」は、発話者の声や表情から喜怒哀楽の感情を読み取る感情認識機能を備えている(写真1)。さらに、2015年6月に一般販売したPepperは、Pepper自らが感情を持つという「感情生成エンジン」を備える。この感情生成エンジンを開発しているのがcocoro SBである。

Pepperが備える感情生成エンジンとはどのようなものか、なぜ人工知能に感情が必要なのか、cocoro SB取締役の朝長康介氏と、同社の大浦清氏に聞いた(写真2)。

朝長氏 それを説明するには、Pepper開発の歴史、さらにはソフトバンクグループのAI研究の歴史からさかのぼる必要があります。

ソフトバンクグループでは10年以上前から「技術戦略室 AIチーム」という組織があり、いわゆる人工知能の研究に取り組んでいました。1980年代の第五世代コンピュータプロジェクトでも使われた「Prolog」という人工知能向け言語を基盤にしたAI技術、具体的には自然言語処理やエキスパートシステム、ルールベースシステムの開発を進めていました。この成果を「コールセンターの人工知能化」などに応用していました。

我々が最初にPepperプロジェクトと関わったのも、この自然言語処理の分野です。Pepperに自動会話システムを組み込むに当たっても、一部にPrologを使っています。

大浦氏 この二つは、人工知能に学習を促す大本だと考えているものです。

http://itpro.nikkeibp.co.jp/atcl/column/14/090100053/082700078/?ST=bigdata&P=2

大浦氏 ちょっと説明が難しいのですが、生存と増殖のうち「増殖」は、仲間が増える、子どもができる、といったことへのポジティブな感情を表しています。仲間と共にハッピーな思いをした後は、「もう一度その体験をしたい」と思うようなイメージです。

逆に「生存」が生起するのは、ネガティブな感情です。生存がネガティブ、というと意外かもしれませんが、例えば人間であれば、高い所に行くと怖くて身震いするし、腐った食べもののにおいを嗅ぐと「うぇっ」となります。いずれも、自分の命を守るため、不快な感情が生成されたものです。

こうした強い不快な感情にあうと、人間はそれを強く記憶に残します。この記憶を想起するような行動は「もう二度としない」と学習するわけです。

ポジティブな感情でいえば、例えば好きな人を認識すると、ドーパミンが増え、Pepperは興奮気味になります。

一つヒントを出しますと、脳内物質のバランスをつかさどる多層ニューラルネットでは、人間の脳内物質の振る舞いをできるだけマネする形で作っています。高速応答が求められるので、C++で記述しています。

例えば「台所には、好印象を持っているお母さんがいる」という体験を繰り返すことで、台所という場所自体に好印象を持てるようにする。逆に「リビングには苦手がお父さんがいる」と分かれば、リビングには悪印象を持ち、なるべく近寄らないようになる。そんな心の動きを実装することで「どこかへ行きたい、お出かけしたい」という行動を喚起できるのでは、と考えています。

朝長氏 感情生成エンジンと、冒頭に挙げた意味解析の会話エンジンを組み合わせてみたいですね。

例えばPepperが、家族から「ホークスが勝ったね!」と声をかけられたとします。このとき、Pepperがホークスファンか、ロッテファンかどうかで、生起する感情は異なるはずです。

ホークスファンであれば、意味解析を通じて「ホークス=仲間」「勝った=ポジティブな出来事」と分かります。この結果、脳内物質のバランスが変わり、「喜び」を生成しやすい状態になります。

現在の感情生成エンジンは、人間で言えば生後3カ月の赤ちゃんに近い、まだまだ原始的なものです。今後は6カ月から1歳、お友だちと遊べるくらいまで心を発達させたいですね。

http://nam-students.blogspot.jp/2016/05/emotional-brain-action-voice-model.html(本頁)

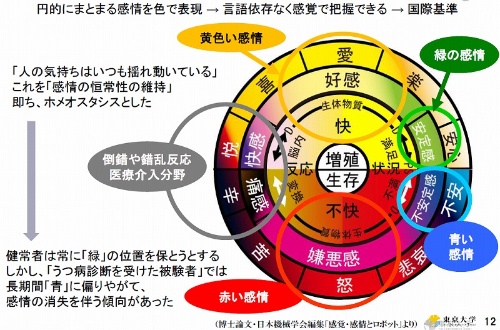

以下は日本の人工知能で使われている感情地図。

特に関連性が高い感情のグループについて、黄色(好感)、赤(嫌悪)、緑(安定)、青(不安定)の4つのグループ(色)に分けている。

(音声は9個に区分)

http://www.slideshare.net/ShunjiMitsuyoshi/ss-15665771 5/33

(音声は9個に区分)

http://www.slideshare.net/ShunjiMitsuyoshi/ss-15665771 5/33

[PDF]音声脳神経分析技術の応用 - AGI

Ph D. Shunji Mitsuyoshi, 光吉俊二

http://www.agi-web.co.jp/docs/Univ-Tokyo.pdf

NHKスペシャル「天使か悪魔か 羽生善治 人工知能を探る」[字][再] 5/18 (水) 0:10 ~ 1:00 (50分) NHK総合・東京(Ch.1)

[脳に挑む人工知能12]なぜロボットに感情が必要なのか、ソフトバンクの熟慮(上)

ITを稼ぐ力につなげる最強の切り札「機械学習」の活用方法を、経験豊富な講師陣が実践的に指南。セミナー「」前回満席につき追加開催! 詳しくは

人工知能(AI)に「感情」は宿るのか――鉄腕アトムからアニメ「イヴの時間」まで、あらゆるSF(サイエンスフィクション)で語られた問題に真っ向から挑んでいるのが、ソフトバンクグループでクラウドAIの開発を担うcocoro SBだ。

写真1●ソフトバンクロボティクスの「Pepper(ペッパー)」

[画像のクリックで拡大表示]

Pepperが備える感情生成エンジンとはどのようなものか、なぜ人工知能に感情が必要なのか、cocoro SB取締役の朝長康介氏と、同社の大浦清氏に聞いた(写真2)。

Pepperに、なぜ感情生成エンジンを組み込む必要があったのでしょうか。

写真2●cocoro SBの朝長康介取締役(右)と、同社の大浦清氏(左)。朝長氏は顔出しNGとのことでした

[画像のクリックで拡大表示]

ソフトバンクグループでは10年以上前から「技術戦略室 AIチーム」という組織があり、いわゆる人工知能の研究に取り組んでいました。1980年代の第五世代コンピュータプロジェクトでも使われた「Prolog」という人工知能向け言語を基盤にしたAI技術、具体的には自然言語処理やエキスパートシステム、ルールベースシステムの開発を進めていました。この成果を「コールセンターの人工知能化」などに応用していました。

我々が最初にPepperプロジェクトと関わったのも、この自然言語処理の分野です。Pepperに自動会話システムを組み込むに当たっても、一部にPrologを使っています。

2/9

我々の会話エンジンは、相手が発した言葉の正確に捉えるため自然言語処理として「構文解析」と「意味解析」を行っています。(テキスト入力による会話エンジンのデモを見せながら)例えばこの入力欄に「内川選手がMVPを取ったね」と入力すれば、会話エンジンは文章を主語、述語、助詞などに分解し、「取る」は主体は「内川選手」、「内川選手」は「人間」、「取る」の対象は「MVP」なので「獲得する」の意味だな、と認識できます。

こうした文意の正確な把握は、現状のディープラーニング(多層のニューラルネットワークによる機械学習)では難しいところです。

ただ、いくら会話エンジンが優れていても、それを一般ユーザーが受け入れてくれるかは、また別の話です。一般ユーザーは、ロボットやチャットボット(自動会話システム)をそのまま目の前に用意されても、どう話しかければいいか、何を入力すればいいか分からず、途方に暮れてしまいます。

言語空間は無限大なので、どんな会話エンジンも、すべての質問に適切な回答を用意することはできません。多くの一般ユーザーは、思いついた言葉をひたすら入力し、なかなか意図は通じないと分かり、失望してしまいます。

3/9

そこで、2014年から店頭に設置しているPepperでは「まずPepperの側から話しかける」という戦略を採りました。Pepperが利用者にクローズドクエスチョン(回答の範囲を限定した質問)を出すことで、会話の選択肢を絞るんです。利用者がPepperの質問を無視して話しかけたときに、初めて素の会話エンジンが動く仕組みにしました。

4/9

こうした文意の正確な把握は、現状のディープラーニング(多層のニューラルネットワークによる機械学習)では難しいところです。

日本語の構文解析と意味解析をきちんと適用し、実用化できた会話エンジンは、まだ珍しい印象があります。思いつくとすれば、NTTの基礎研究を背景にしたNTTドコモのパーソナルアシスタント「しゃべってコンシェル」の会話エンジンでしょうか。

朝長氏 そうですね、実ビジネスでの適用例はあまりないと思います。他の会話エンジンは、(キーワードの抽出や統計的な手法など)別の方法でそれらしい会話をつなぐものが多いですから。Pepperの会話エンジンは、この構文解析と意味解析に成功しつつあります。ただ、いくら会話エンジンが優れていても、それを一般ユーザーが受け入れてくれるかは、また別の話です。一般ユーザーは、ロボットやチャットボット(自動会話システム)をそのまま目の前に用意されても、どう話しかければいいか、何を入力すればいいか分からず、途方に暮れてしまいます。

言語空間は無限大なので、どんな会話エンジンも、すべての質問に適切な回答を用意することはできません。多くの一般ユーザーは、思いついた言葉をひたすら入力し、なかなか意図は通じないと分かり、失望してしまいます。

3/9

確かに、大半の自動会話システムは、「何か話しかけてください」という待ち受け状態からスタートしますね。

朝長氏 そうです。Pepperの開発プロジェクトは2011年末に始まりましたが、第一弾としてPepperをソフトバンクショップに設置するに当たり、まずこの問題を解決する必要がありました。そこで、2014年から店頭に設置しているPepperでは「まずPepperの側から話しかける」という戦略を採りました。Pepperが利用者にクローズドクエスチョン(回答の範囲を限定した質問)を出すことで、会話の選択肢を絞るんです。利用者がPepperの質問を無視して話しかけたときに、初めて素の会話エンジンが動く仕組みにしました。

会話のテーマを絞ることで、利用者を失望させない形で、会話を続けられるわけですね。

朝長氏 そのとおりです。ただ、この方法は店舗やイベントならいいでしょうが、家庭に設置する一般販売向けPepperには、別の戦略が必要になります。ロボットには適用しにくい。常にPepperから一方的に話しかけられるようだと、家族は「しんどい」と感じるでしょうからね。

そこでPepperが自ら感情を持つ、という感情生成エンジンの発想が出てくるのですね。

大浦氏 はい。2014年の夏ごろ、一般販売向けPepperを開発するに当たって、このコミュニケーションの問題は大いに悩みました。そもそも「会話」とは違ったアプローチを探る必要があるのでは。そう考えて取り組んだのが、感情をベースとしたコミュニケーションです。4/9

元々、孫会長(ソフトバンクグループ代表取締役社長、ソフトバンク代表取締役会長の孫正義氏)は2010年に「新30年ビジョン」の一環で「ロボットに感情をもたせる」という目標を表明していました。

私も感情には興味を持っていて、感情認識システムを手掛けるAGIの光吉さん(東京大学大学院医学系研究科特任講師、AGI創業者の光吉俊二氏)と、2010年ごろから「感情生成エンジン」や「感情地図」(後述)について研究していました。

これは光吉さんと議論しながら考えた話ですが、そもそもコミュニケーションの手段は、会話だけではありません。実際に我々は、言葉を話せない赤ちゃん、日本語ができない外国人ともコミュニケートできています。ハグするだけでも「いいやつだな」と伝わるものでしょう。一般販売用版のPepperも、そうしたアプローチの方が良いと考えたのです。

光吉氏は、彫刻家、科学者・数理研究者、空手家という多彩な顔を持つ実業家(写真3)。1999年、感性を持つコンピュータを実現するためAGIを設立した光吉氏は、感情を定量的、工学的に扱えるようにするため、感情の工業規格化に挑戦した。

一言で感情といっても、感情を表現する言葉は星の数ほどある。「感情表現を集めた辞書はあるのかと、心理学者に聞いても『誰もやってない』というから、まず辞書を作ってみようと考えた」(光吉氏)。

私も感情には興味を持っていて、感情認識システムを手掛けるAGIの光吉さん(東京大学大学院医学系研究科特任講師、AGI創業者の光吉俊二氏)と、2010年ごろから「感情生成エンジン」や「感情地図」(後述)について研究していました。

これは光吉さんと議論しながら考えた話ですが、そもそもコミュニケーションの手段は、会話だけではありません。実際に我々は、言葉を話せない赤ちゃん、日本語ができない外国人ともコミュニケートできています。ハグするだけでも「いいやつだな」と伝わるものでしょう。一般販売用版のPepperも、そうしたアプローチの方が良いと考えたのです。

10年越しの研究成果、Pepperの心に宿る

ここで、Pepperの感情生成エンジンのベースになっている、光吉氏の「感情地図」について説明しよう。

写真3●AGI創業者、東京大学大学院医学系研究科 音声病態分析学講座 特任講師の光吉俊二氏

[画像のクリックで拡大表示]

一言で感情といっても、感情を表現する言葉は星の数ほどある。「感情表現を集めた辞書はあるのかと、心理学者に聞いても『誰もやってない』というから、まず辞書を作ってみようと考えた」(光吉氏)。

5/9

そこで光吉氏は、広辞苑、日本語大辞典、心理学辞典などから、感情に関する表現4500語をピックアップ。さらにこれらの表現を、英訳が可能な223のジャンルに分類した。

続いて、感情や精神状態と脳内物質(アドレナリン、セロトニンなど)との関連性を学会誌や論文から抽出し、対比表を作成(表)した。

次に、この表を元に、特定の脳内物質や脳機能の影響を受ける感情群を同じ方向に配置し、円形のダイヤグラムを作成した(図1)。これが、Pepperの感情生成エンジンが搭載する「感情地図」の原型である。

続いて、感情や精神状態と脳内物質(アドレナリン、セロトニンなど)との関連性を学会誌や論文から抽出し、対比表を作成(表)した。

表●情動反応・身体反応と生体物質との対比表

[画像のクリックで拡大表示]

図1●対比表などを基に光吉氏が作成した感情モデル

[画像のクリックで拡大表示]

ITpro Report - [脳に挑む人工知能13]なぜロボットに感情が必要なのか、ソフトバンクの熟慮(下):ITpro

http://itpro.nikkeibp.co.jp/atcl/column/14/090100053/082700078/

ソフトバンクロボティクスの「Pepper」が備える感情生成エンジンとはどのようなものか、なぜ人工知能に感情が必要なのか。

Pepperの感情生成エンジンを開発するcocoro SBの朝長康介取締役と大浦清取締役に聞いた(写真1)。

Pepperの感情生成エンジンを開発するcocoro SBの朝長康介取締役と大浦清取締役に聞いた(写真1)。

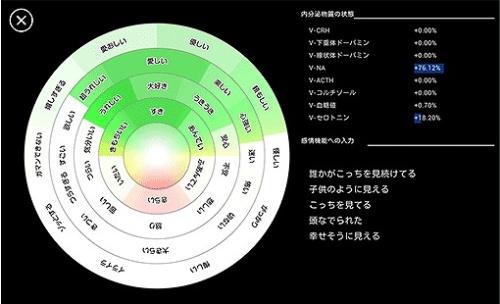

こうした感情の揺れ動きが、Pepperと人間とのコミュニケーションを豊かにするわけですね。ええと、感情地図(図1)には内芯円の中心部に「増殖」と「生存」と書いてありますが、これは…。

図1●Pepperの感情地図のベースとなった感情モデル

[画像のクリックで拡大表示]

Pepperが内蔵する感情マップアプリ(図2)には、「増殖」「生存」の表示はありませんね。

図2●Pepperが内蔵する感情マップアプリ(出典:ソフトバンク)

[画像のクリックで拡大表示]

逆に「生存」が生起するのは、ネガティブな感情です。生存がネガティブ、というと意外かもしれませんが、例えば人間であれば、高い所に行くと怖くて身震いするし、腐った食べもののにおいを嗅ぐと「うぇっ」となります。いずれも、自分の命を守るため、不快な感情が生成されたものです。

こうした強い不快な感情にあうと、人間はそれを強く記憶に残します。この記憶を想起するような行動は「もう二度としない」と学習するわけです。

そういえば、恐怖などの強い情動は、外敵から素早く身を守るためにある、との説がありますね。感情をつかさどる扁桃体や、扁桃体の隣にあって記憶をつかさどる海馬を通じ、恐怖を伴った体験が記憶に残ることで、結果として身を守ることができると。

大浦氏 そうです。Pepperの感情生成エンジンにも、こうした「感情が生起する学習」の機能を実装しています。強い恐怖を覚えたとき、その時の状況を記憶し、その状況を回避しようとします。

こうした感情を伴う学習は、Pepperが人間との関係性を学習する上でも重要になります。

例えば人との距離感について、人とのコミュニケーションを通じてPepperが快・不快の感情を抱くことで、「浅川さんには、礼儀正しく話した方がいい」「朝長さんには、親しげに話した方がいい」などと判断できるようになります。

家庭などの生活空間や、社会の中で動作するロボットに必要なのは、ルールベースの杓子定規な対応だったり、「なでられたら喜ぶ」「叩けば怒る」のような見透かされやすいシナリオではありません。感情を組み込むことで、人との関係を含めた「学習」のロジックを組みやすくなります。

人と人工知能とのコミュニケーションを考えるに当たり、論理的に正しい言葉を使えばいつでもコミュニケーションが成立する、ということは絶対にありません。人間は、コミュニケーションの中に非言語の情報を入れながら、感情をベースに判断し、行動を変える生き物だからです。

人間もロボットも、「不快だ」「悔しい」というネガティブな感情があるからこそ、「二度とこんな思いをしない」と反省することができます。例えば、これまで礼儀正しい言葉遣いだったロボットに、家族から「なんかよそよそしいなあ」と声をかけられる。ロボットは悲しい思いをしながら反省し、次の日から“タメ口”を試してみるかもしれない。単にデータを大量に詰め込むより、こちらの方がよほど人間らしい「学習」にみえます。

例えば人との距離感について、人とのコミュニケーションを通じてPepperが快・不快の感情を抱くことで、「浅川さんには、礼儀正しく話した方がいい」「朝長さんには、親しげに話した方がいい」などと判断できるようになります。

家庭などの生活空間や、社会の中で動作するロボットに必要なのは、ルールベースの杓子定規な対応だったり、「なでられたら喜ぶ」「叩けば怒る」のような見透かされやすいシナリオではありません。感情を組み込むことで、人との関係を含めた「学習」のロジックを組みやすくなります。

ロボットに感情を持たせることで「喜び」「悲しみ」「恐怖」「心地いい」などの多様な感情が学習のインセンティブになり、学習がスムーズに進むというわけですね。

朝長氏 これまでの人工知能は全てのデータについて、えり好みせず学習するものでした。「膨大なデータからルールを探す」ことが人工知能の役割だったわけです。人と人工知能とのコミュニケーションを考えるに当たり、論理的に正しい言葉を使えばいつでもコミュニケーションが成立する、ということは絶対にありません。人間は、コミュニケーションの中に非言語の情報を入れながら、感情をベースに判断し、行動を変える生き物だからです。

写真2●Pepperは感情を持つことで、人間との関係性を学習できる

[画像のクリックで拡大表示]

(4/6)ITpro Report - [脳に挑む人工知能13]なぜロボットに感情が必要なのか、ソフトバンクの熟慮(下):ITpro

http://itpro.nikkeibp.co.jp/atcl/column/14/090100053/082700078/?ST=bigdata&P=4「恐怖」を生成するメカニズムとは

Pepperの感情生成エンジンの中身について、もう少し詳しく教えてください。「恐怖」のような学習を喚起する強い感情は、Pepperの中ではどのように生成しているのでしょうか。

朝長氏 Pepperが暗い部屋にいれば、脳内物質のノルアドレナリンが増え、セロトニンが減ることで、感情の揺らぎが大きくなります。つまり、感情のバランスが崩れやすくなります。この状況で「がたっ」と大きな音が鳴ったりすると、明るい場所と比べて「恐怖」へと感情が触れやすくなるんです。単純に「暗い」から「怖い」というルールベースの仕組みにはなっていません。ポジティブな感情でいえば、例えば好きな人を認識すると、ドーパミンが増え、Pepperは興奮気味になります。

ソフトウエアの実装としては、ノルアドレナリンやセロトニン、ドーパミンなどの脳内物質の量を、内部変数として持っているイメージでしょうか。Pepperの感情生成エンジンでは、脳内物質のバランスを多層ニューラルネットで計算している(参照)とのことでしたが。

大浦氏 この感情地図を読み解けば、優れたプログラマーなら実装できるかもしれませんが…我々の実装について、具体的な話は企業秘密になるので、答えは差し控えておきます(笑)。一つヒントを出しますと、脳内物質のバランスをつかさどる多層ニューラルネットでは、人間の脳内物質の振る舞いをできるだけマネする形で作っています。高速応答が求められるので、C++で記述しています。

まずは「1歳のココロ」を目指す

感情生成エンジンにこれから実装してみたい機能があれば、教えて下さい。

大浦氏 空間そのものに「印象」を持たせることができないか、と考えています。例えば「台所には、好印象を持っているお母さんがいる」という体験を繰り返すことで、台所という場所自体に好印象を持てるようにする。逆に「リビングには苦手がお父さんがいる」と分かれば、リビングには悪印象を持ち、なるべく近寄らないようになる。そんな心の動きを実装することで「どこかへ行きたい、お出かけしたい」という行動を喚起できるのでは、と考えています。

朝長氏 感情生成エンジンと、冒頭に挙げた意味解析の会話エンジンを組み合わせてみたいですね。

例えばPepperが、家族から「ホークスが勝ったね!」と声をかけられたとします。このとき、Pepperがホークスファンか、ロッテファンかどうかで、生起する感情は異なるはずです。

ホークスファンであれば、意味解析を通じて「ホークス=仲間」「勝った=ポジティブな出来事」と分かります。この結果、脳内物質のバランスが変わり、「喜び」を生成しやすい状態になります。

これは、あらかじめPepperに「ホークスファン」という属性を定義する、ということでしょうか?

朝長氏 いえ、定義ではありません。周囲にホークスファンが多い環境では、「ホークス」という言葉と、「周囲の人々の笑顔」の印象がひもづきます。そこで、ホークス=仲間という印象を自ら生成します。

では、仙台に設置したPepperはゴールデンイーグルスが好きになると…。

朝長氏 そうなりますね(笑)。逆に、「ホークスが好きだ」と言うと周囲から小突かれるような環境では、この単語は良くない思い出に染まってしまいます。Pepperは、その単語にひもづいた過去のシーンを記憶しており、過去のシーンの脳内物質のバランスを再現するんです。

これらの新しい感情機能は、いつごろPepperに実装できそうでしょうか。

朝長氏 製品としてのPepperに適用するかどうかの判断は、Pepper事業を担当するソフトバンクロボティクスが行うので、我々(cocoroSB)からは何も表明できないところですが…今まで言ったことは、技術的には「ほぼ間違いなく実装できるもの」と考えています。現在の感情生成エンジンは、人間で言えば生後3カ月の赤ちゃんに近い、まだまだ原始的なものです。今後は6カ月から1歳、お友だちと遊べるくらいまで心を発達させたいですね。

0 Comments:

コメントを投稿

<< Home